GPT-OSS es un modelo de inteligencia artificial de código abierto que replica las funcionalidades de ChatGPT, pero funciona plenamente desde nuestro PC, sin pasar por servidores de por medio y sin depender de empresas como OpenAI. Pero… ¿Qué trae para nosotros toda esta interfaz de IA?

Gracias a Ollama, su instalación es tan sencilla que prácticamente cualquier usuario puede tener su «propio ChatGPT» privado, ilimitado y gratuito en cuestión de minutos. No hay ningún tipo de suscripción ni pagos mensuales, así como tampoco límites de uso, y la privacidad es absoluta.

Por lo tanto, en esta guía te vamos a mostrar cómo instalar GPT-OSS en Windows y comenzar a usar una IA de nivel profesional sin gastar un solo euro.

¿Qué puedes hacer con GPT-OSS?

GPT-OSS es un modelo de lenguaje abierto que nos permite realizar casi cualquier tarea que haríamos con ChatGPT de manera online. Pero la principal diferencia es que funciona íntegramente dentro de nuestro PC. Nada de restricciones comerciales ni límite de consultas, por lo que las posibilidades son ilimitadas.

Con GPT-OSS, podemos generar textos de cualquier tipo. Desde redactar correos con aspecto profesional hasta crear contenido para redes sociales, escribir historias, podemas o guiones, resumir documentos largos, analizar textos…

Y no solo eso, sino que también es perfecta para tareas técnicas. Tales como explicar código, corregir errores de programación o ayudarnos a aprender lenguajes nuevos. Incluso también puede resolver problemas matemáticos o lógicos y ofrecer soluciones a problemas de desarrollo.

En cuanto a la productividad personal, también es capaz de planificar proyectos o a ayudarnos con el brainstorming creativo, analizar información o responder preguntas sobre cualquier tema de nuestro interés. Por lo tanto, si eres estudiante, profesional, escritor o programador, GPT-OSS se adapta a ti.

Ventajas de usar una IA local

El hecho de ejecutar un modelo de IA directamente en nuestro Windows nos ofrece ventajas que los servicios online no pueden igualar hasta el momento.

La principal de ellas es que la privacidad es absoluta. Es decir, que cda conversación, pregunta o dato que procese la IA se queda en nuestro propio PC. No hay servidores remotos registrando nuestra actividad ni analizando nuestros textos para vender nuestros datos. Lo que nos lleva a la siguiente ventaja: la seguridad de nuestros datos está garantizada. Si no hay transmisión de información hacia un servidor, todos nuestros documentos confidenciales se quedan bajo nuestra propia custodia.

Aparte de ello, tenemos plena libertad económica. Sin ir más lejos, ChatGPT Plus tiene un precio de 20 dólares al mes. Una cifra parecida que podemos encontrar en Gemini, Claude y demás servicios similares. GPT-OSS es 100% gratuito, y consta de una única descarga. Nada de suscripciones o sorpresas.

También hemos de tener en cuenta el control y la personalización que tenemos con este modelo. Podemos ajustar parámetros, cambiar el comportamiento del modelo e incluso integrarlo en nuestras apps. Todo para que funcione exactamente como queramos y no depender de las decisiones de una megacorporación

Aun así, también hemos de tener en cuenta que este tipo de modelos de local tendrá una velocidad que variará según nuestro hardware. Por lo tanto, es importante que dispongamos de una GPU potente, como NVIDIA o AMD, para que el modelo responda lo antes posible. De esta manera, evitaremos cuellos de botella y cualquier tipo de latencia.

Requisitos

Para instalar utilizar GPT-OSS en Windows, necesitaremos cumplir con algunos requisitos, pero la buena noticia es que no son exigentes. El sistema operativo deberá ser, o bien Windows 10, o bien Windows 11, ambos de 64 bits.

Con respecto a la memoria RAM, hablamos de uno de los factores más importantes. Para la versión de GPT-OSS:20b (el modelo más ligero), la recomendación mínima es de 8 GB de RAM, aunque 16 GB nos garantiza una experiencia fluida.

Pero estos requisitos cambian para el modelo más potente de todos, GPT-OSS:120b. En este caso, al menos necesitamos 16 GB de RAM, aunque lo ideal para un rendimiento óptimo es de 32 GB.

El procesador también es parte fundamental para esta ecuación:

- Intel Core i5 de cuarta generación en adelante.

- AMD Ryzen 3 o superior.

No es necesario utilizar el procesador más potente, pero sí importante evitar los antiguos.

Otro factor crucial es tanto nuestro disco como su capacidad. Lo recomendable es que dispongamos de un SSD con, al menos, 500 GB libres. No es que los modelos ocupen tal cantidad de datos por sí mismos, pero sí nos permite un margen de espacio suficiente para instalarlos y aumentarlos sin problema. GPT-OSS:20b ocupa unos 13 GB, mientras que 120b ocupa hasta 70 GB.

Y llegamos al apartado más importante dentro de los requisitos: la tarjeta gráfica o GPU. Este hardware, que incide directamente también en el rendimiento de tus juegos, también acelera enormemente los modelos de IA.

Si cuentas con:

- NVIDIA GeForce RTX 3060 en adelante

- AMD Radeon RX 6700 en adelante

Tendrás un funcionamiento óptimo. Aunque los modelos anteriores también sirven, el rendimiento decaerá aunque siga siendo perfectamente utilizable. En caso de no disponer de GPU, el modelo también funciona con la CPU, pero de manera notablemente más lenta. En el caso de que tu PC tenga una GPU integrada, también puede ayudar, pero nunca al nivel de una dedicada.

Por último, también necesitarás conexión a internet, aunque esta solo es necesaria para descargar el modelo, una sola vez, y no de manera recurrente. Una vez descargado, GPT-OSS funciona de manera offline permanentemente.

| Componente | Requisito Mínimo (Modelo 20b) | Requisito Óptimo (Modelo 120b) |

|---|---|---|

| Sistema Operativo | Windows 10 / 11 (64-bit) | Windows 10 / 11 (64-bit) |

| Memoria RAM | 16 GB | 32 GB o más |

| Procesador (CPU) | Intel Core i5 (4ª gen+) / AMD Ryzen 3+ | Intel Core i7 (8ª gen+) / AMD Ryzen 7+ |

| Almacenamiento | SSD con 50 GB libres | SSD (NVMe) con 150 GB libres |

| Tarjeta Gráfica (GPU) | NVIDIA RTX 3060 (8GB+) / AMD RX 6700 (10GB+) | NVIDIA RTX 3090 / 4070 (12GB+) |

GPT-OSS con Ollama

Antes de utilizar el modelo de lenguaje GPT-OSS, necesitamos instalar un «lanzador», o app que lo soporte. Y la más optimizad para ello es Ollama. Instalarla en Windows es un proceso sencillo y apto para prácticamente cualquier usuario. El equipo de Ollama ha desarrollado un instalador gráfico que elimina la necesidad de utilizar comandos y configuraciones más complejas. Pero empecemos por el principio.

Todo empieza al acceder a la web oficial de descargas de Ollama. El único sitio seguro y legítimo a la hora de obtener los archivos necesarios. Desde ella, solo tenemos que descargar el archivo «OllamaSetup.exe» que encontrarás para Windows. Solo tienes que pulsar en el link para que te lleve a la descarga y pulses sobre la misma.

Eso sí, antes de ejecutar su instalador, deberás verificar que tu PC cumple, al menos, con los requisitos básicos:

- Sistema operativo de Windows 10 u 11 de 64 bits.

- 8 GB de capacidad de memoria RAM.

- CPU x86 con, al menos, cuatro núcleos. Por ejemplo, Intel Core i5/i7 de cuarta generación o AMD Ryzen 3/5/7.

- Opcionalmente, una GPU dedicada de NVIDIA o AMD mejora el rendimiento. Aun así, no es imprescindible para los modelos de IA más ligeros (Pero tal y como te hemos dicho para GPT-OSS, sí es muy recomendable).

Cómo seleccionar GPT-OSS entre los modelos de Ollama

Una vez que descarguemos la app (que pesa 1,2 GB), la instalaremos como cualquier otro programa, y cuando ejecutemos por primera vez Ollama, encontraremos esta interfaz:

Como puedes ver de manera clara en la imagen, nos apareceráun recuadro central, justo bajo el logo oficial del programa, donde encontraremos la sección que necesitamos para esta ocasión: «Select a model».

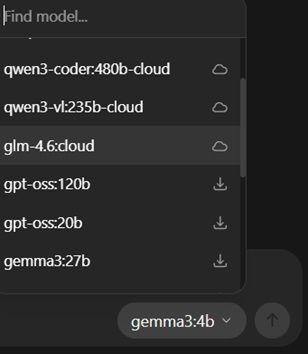

Al pulsar sobre ella, se desplegará una serie de modelos disponibles para descargar y utilizar desde la propia Ollama:

Como puedes ver en la imagen de arriba, cuando pulsamos sobre el selector de modelos, se nos abren modelos disponibles tanto para utilizar en la nube como para descargar. Y encontrarás justo lo que buscamos: «gpt-oss:20b» y «gpt-oss120b».

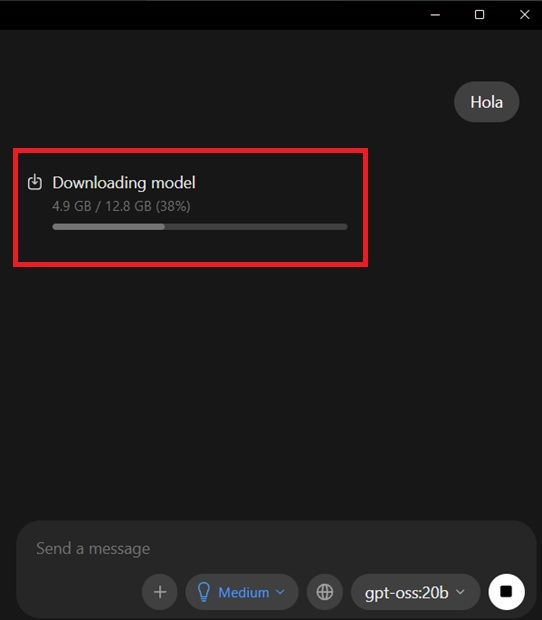

Recuerda que el 20b es el modelo ligero, de menor peso, mientras que el 120b ocupa casi 70 gb de peso. Selecciones el que selecciones, deberás esperar a que Ollama haga la correspondiente descarga, cuestión de segundos o minutos. En este caso, para comenzar a descargar, deberás seleccionarlo desde la columna de modelos y escribir cualquier mensaje en el cuadro de texto para enviarlo:

Una vez que se haya descargado, estaremos listos para utilizar GPT-OSS:20b de manera local. Por lo que tendremos un asistente en nuestro propio PC para preguntarle prácticamente cualquier cuestión que nos surja con cualquier tema, pero lo más importante es que nada pasará por ningún servidor externo.

GPT-OSS con LM Studio

LM Studio es una alternativa a Ollama, pero que cumple con sus mismas funciones. En este caso, también ofrece una interfaz sencilla, amigable para cualquier tipo de usuario que prefiere un entorno gráfico al uso del terminal. Mientras que Ollama es extremadamente simple y eficiente, LM Studio cuenta con una interfaz más moderna y más opciones de personalización. Es decir, que si buscas un diseño más parecido al ChatGPT real, puede ser la opción que quieras escoger.

Pero lo primero y más importante… ¿Qué requisitos tiene LM Studio para instalarse en nuestro PC? En este apartado, encontramos, para su versión de Windows:

- CPU de 64 bits con soporte AVX2.

- RAM: 16 GB recomendadas para modelos de 7-8B. Aunque con 8 GB se puede empezar con modelos pequeños de 3-4B y contextos cortos.

- La GPU no es obligatoria, pero recomendable si se quiere acelerar.

- En cuanto al almacenamiento, cada modelo ocupa de 2 a algo más de 20 GB (aunque GPT-OSS:20b llega a los 70) según el tamaño y la cantidad. Así que deberemos reservar en el disco duro una media mínima de unos 100 GB si queremos optar por más de un modelo.

Para descargar el instalador oficial para Windows, solo deberemos acudir a su web oficial, dentro del selector de descargas para los distintos sistemas operativos. En nuestro caso, vamos a descargar la última versión disponible para Windows, con un peso de 516 MB.

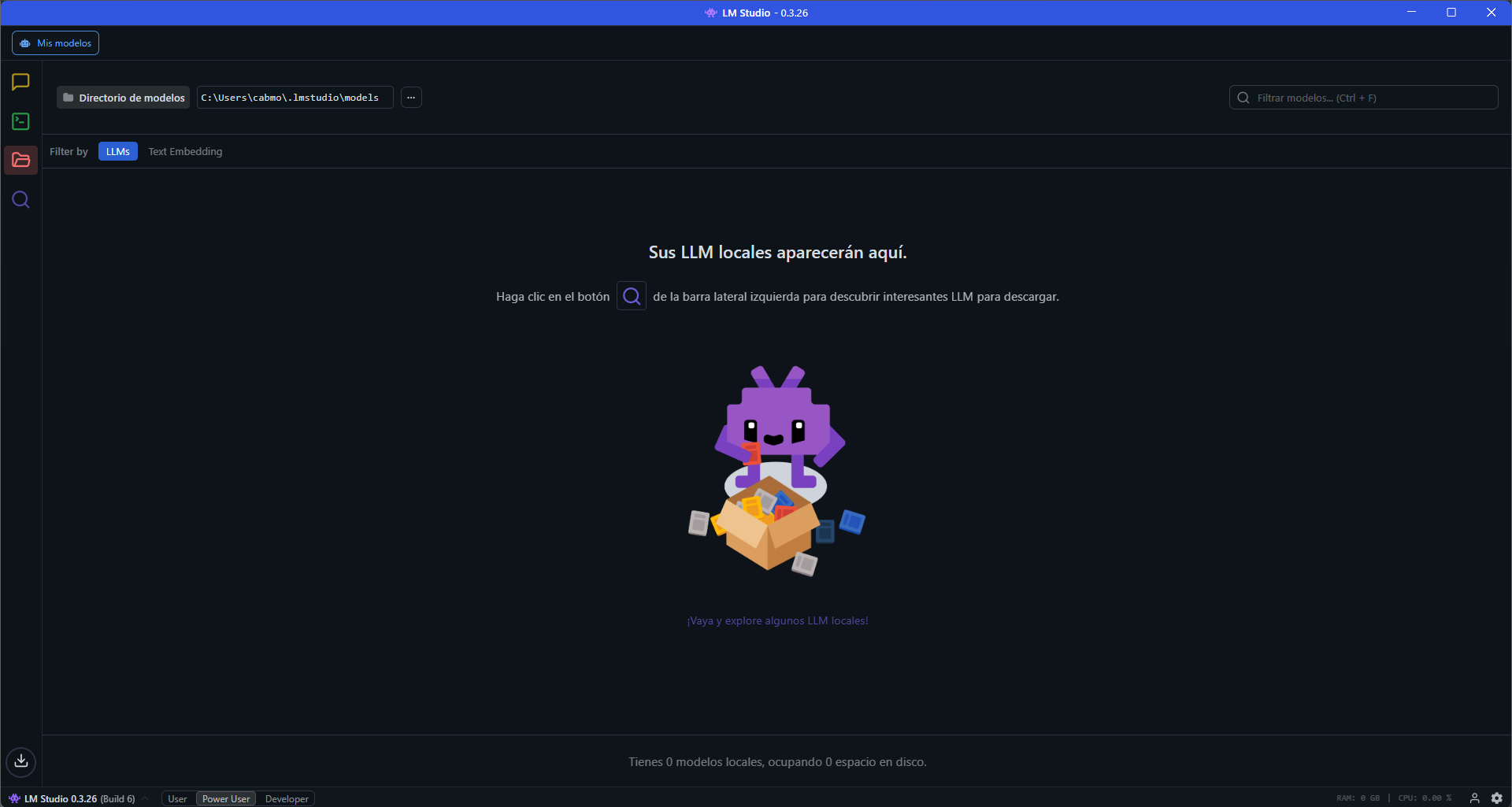

Se te descargará un archivo «.exe» que deberás ejecutar para su instalación. Luego elige la carpeta de destino donde se ubicará LM Studio, donde se nos requerirá 1.7 GB de espacio para ello. Una vez la tengamos, solo deberemos pulsar sobre «Instalar». Cuando hayas finalizado, encontrarás su interfaz principal lista para ser usada:

Pasos para descargar y utilizar GPT-OSS en LM Studio

La lupa morada de la parte izquierda de la imagen de arriba será nuestro próximo destino. Al pulsar en dicha sección, encontraremos un listado con todos los modelos de que dispone LM Studio para su ejecución en local. Dispone de varios de ellos, pero nosotros vamos a centrarnos, tal y como venimos explicando a lo largo del artículo, en GPT-OSS:20b:

Una vez que hayamos pulsado sobre «Download», tan solo deberemos esperar a que dicho modelo se descargue con normalidad. Cuando se haya descargdo con éxito, deberemos acudir a la columna de la izquierda y pulsar sobre el icono amarillo de la conversación con el nombre de «Chats». Esperamos a que se expanda la sección, y acudiremos a la pestaña central con el nombre de «Seleccione un modelo para cargar». Encontraremos una configuración inicial antes de que se abra el modelo en sí. Donde, junto al nombre del modelo, deberemos especificar dos parámetros importantes:

- Longitud del contexto: fija cuántos tokens puede «recordar» el modelo dentro de una conversación o tarea. Moverla hacia la derecha aumenta el tope de tokens, mientras que moverlo a la izquierda lo reduce.El hecho de aumentar el contexto hace que se consuma más RAM/VRAM. Si falta memoria, aparecerán errores o cortes. Algo que se acentuará en equipos que dispongan con 8-12 GB de VRAM. Pero si nuestro PC nos lo permite, permite funcionar con hilos de conversación más largos. Ten en cuenta que los contextos grandes implican más cómputo por token, lo que puede hacer que baje la tasa de tokens por segundo en PC más modestos.

- Descarga a GPU: la GPU procesa capas en paralelo y acelera la generación de contenido, especialmente en modelos 7B-20B y superiores. A cambio, hace un mayor uso de VRAM. Si se supera la VRAM disponible, sufrirás caídas de rendimiento, por lo que conviene ajustarlo de manera progresiva antes de que sufra nuestro hardware.

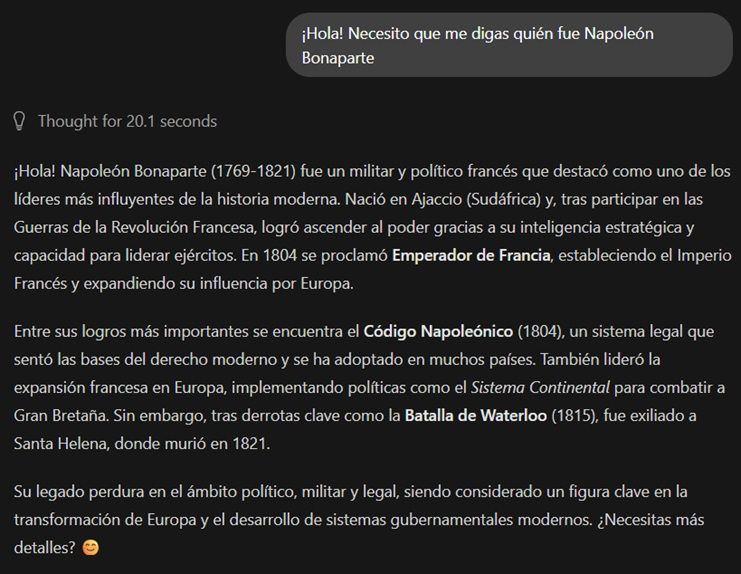

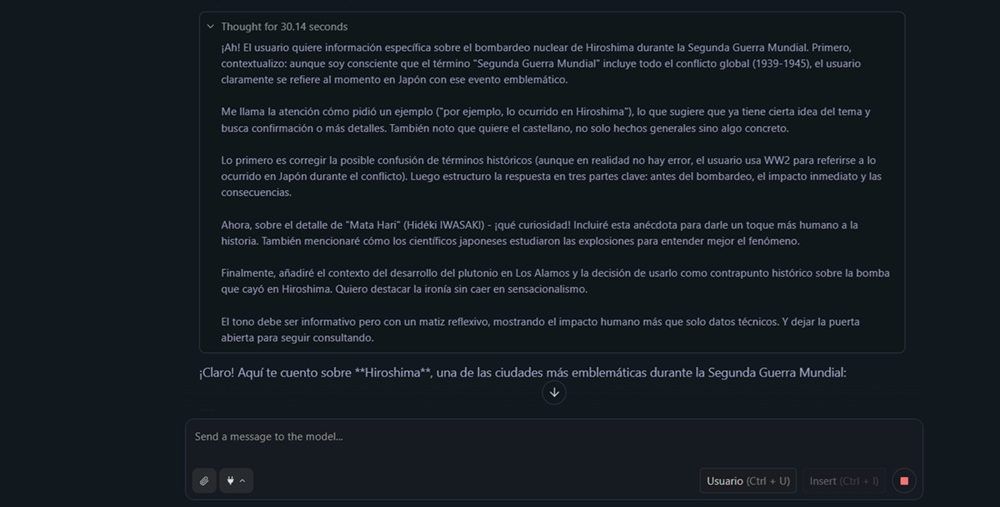

Una vez configurado, solo tendremos que pulsar sobre «Cargar modelo», y nos aparecerá un chat al más puro estilo ChatGPT:

Al comenzar una pregunta, Eel propio modelo nos notifica en todo momento su estructura de pensamiento y las acciones a realizar. Tal y como puedes ver en la imagen de arriba. Por último, tras «pensar», nos mostrará una respuesta acorde a sus tokens y a la información que necesitamos.

Con LM Studio, al igual que con Ollama, no dependerás de ningún servidor online para utilizar los mejores modelos de inteligencia artificial. Recuerda: todo ocurre dentro de tu propio PC.

| Característica | Ollama | LM Studio | Recomendado para… |

|---|---|---|---|

| Interfaz de Usuario | Minimalista, orientada a la terminal y con una app gráfica muy simple. | Interfaz gráfica completa, similar a un IDE, con más opciones visuales. | Ollama para usuarios que prefieren la simplicidad y eficiencia; LM Studio para quienes buscan una experiencia más visual y personalizable. |

| Facilidad de Uso | Extremadamente sencillo. Instalar y ejecutar un modelo es casi inmediato. | Muy sencillo, pero con más parámetros de configuración visibles (contexto, descarga a GPU). | Ambos son fáciles, pero Ollama tiene una curva de aprendizaje prácticamente nula. |

| Control y Personalización | Básico desde la app gráfica, más avanzado vía Modelfile en terminal. | Control granular sobre la asignación de RAM/VRAM y capas de GPU directamente desde la interfaz. | LM Studio ofrece un control más accesible para usuarios no técnicos. |

| Comunidad y Soporte | Muy activo en GitHub, ideal para desarrolladores. | Comunidad activa en Discord, más orientada al usuario final. | Ambos tienen un soporte comunitario sólido. |