DeepSeek es el nombre propio de estos días por derecho propio. Ha sido capaz de competir con titanes como OpenAI o Google con un presupuesto de tan solo 6 millones de euros. Pero todos los idilios tienen sus tormentas, y aquí parece llegar su primera. Según informes de Wiz Research, la IA china ha sufrido su primera brecha importante de seguridad.

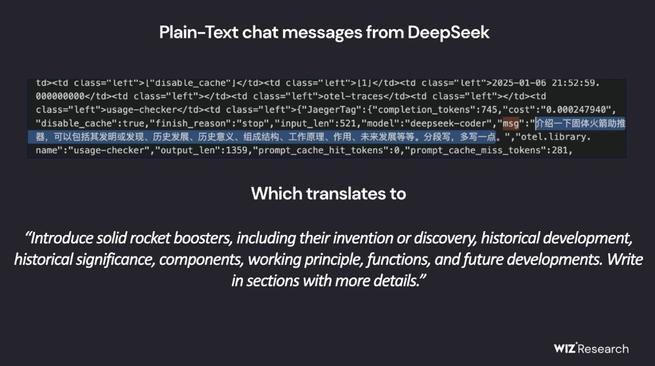

Y es que se ha filtrado una base de datos con conversaciones privadas de los usuarios. Esto puede incluir información sensible y exponer ciertas credenciales de muchos usuarios. Este primer incidente devuelve a sus dueños y usuarios al mundo real y plantea dudas sobre la seguridad de nuestros datos en los modelos de IA referentes en el mundo.

La filtración de datos confidenciales

La investigación de Wiz Research ha sacado a la luz que esta brecha permitió a ciertos actores externos acceder sin mayor problema a las conversaciones generadas en DeepSeek. La compañía aún no ha confirmado el alcance final de dicha brecha, pero se estima que miles (si es que no son millones) de conversaciones con datos sensibles han quedado en manos de completos desconocidos. Entre la información vulnerada, podrían encontrarse datos personales o empresariales… e incluso gubernamentales en algunos casos.

Esta brecha de seguridad ha puesto en alerta al sector tecnológico. Supone una prueba de lo vulnerables que pueden llegar a ser estos sistemas sin una buena base de seguridad.

DeepSeek ya se ha pronunciado, y ha emitido un comunicado en que reconoce la situación y asegura estar trabajando para atajar este problema cuanto antes. Entre las actuaciones por parte de la empresa china, se incluyen mejoras en encriptación de datos, auditorías más rigurosas de seguridad y el desarrollo de algoritmos de acceso más complejos. La realidad es que el daño ya se ha producido, y lo que es peor: sus usuarios comienzan a tener dudas en la plataforma (y, obviamente, no les falta razón).

Durante la investigación de Wiz, esta ha asegurado que la infraestructura de seguridad de DeepSeek imita a la de OpenAI en muchos puntos. Y no está de más recordar que en sus inicios, también ChatGPT sufrió ciberataques que obligó a la empresa americana a reforzar la seguridad.

Todo modelo de IA se diseña bajo la premisa de proteger la privacidad de los usuarios, pero este tipo de incidentes demuestra que aún queda trabajo por hacer. Los gobiernos no son ajenos a estas cuestiones, y existen rumores en occidente de que podrían empezar con regulaciones en breve. Estas irían enfocadas en el almacenamiento y manejo de datos en las herramientas de inteligencia artificial para asegurar nuestra privacidad.

El futuro de DeepSeek se vuelve incierto tras este golpe. Deberán hacer las cosas bien para recuperar la confianza de aquellos usuarios que hayan visto una amenaza en estas noticias. La parte positiva de esta desagradable noticia es que el suceso servirá para poner alerta al resto de empresas de IA. La seguridad es prioritaria a la hora de mantener cualquier proyecto a largo plazo y evitar problemas de cara al futuro.