Al contrario de lo que muchos usuarios piensan, los diferentes asistentes y plataformas relacionados con la inteligencia artificial no son perfectos. Algunos tan populares como por ejemplo sucede con ChatGPT de OpenAI, cometen serios errores que nos pueden poner en un aprieto.

Aquí nos referimos a las llamadas alucinaciones de la IA que en realidad son un fallo bastante habitual en estos chatbots. Cuando, por ejemplo, ChatGPT u otros modelos de IA entregan información errónea, se trata de lo que se denomina como alucinación. La IA puede cometer estos fallos que os mencionamos en las respuestas por diversas razones. En ocasiones se trata de una ligera desviación o un desliz aparentemente inofensivo, pero también nos podemos encontrar con una respuesta difamatoria e inventada.

En cualquier caso, esto es algo que inevitablemente aparecerá si interactuamos con plataformas como la mencionada ChatGPT o sus competidores, durante el tiempo suficiente. Si usamos las respuestas aquí obtenidas para el trabajo o los estudios, en ocasiones nos podemos meter en un lío si nos fiamos al 100 % de las respuestas que nos proporciona la IA de OpenAI.

Llegados a este punto, podemos afirmar que para intentar evitar, en la medida de lo posible, meternos en problemas usando la IA, lo mejor que puede suceder es que detectemos esos errores de manera inmediata. Básicamente con esto lo que os queremos decir es que la clave está en ser conscientes de que una alucinación puede aparecer en cualquier momento. Por tanto, cada vez es más importante conocer las pistas que indiquen que nos encontramos ante uno de esos casos.

Cómo saber si la respuesta de ChatGPT es una alucinación

Es por todo ello por lo que en estas mismas líneas os vamos a mostrar algunos de los indicadores más habituales que nos permitirán detectar que la IA de ChatGPT está alucinando o cometiendo un fallo en ese instante.

Respuestas concretas sin fuentes verificables. Uno de los aspectos más molestos de las alucinaciones de la IA es que a menudo incluyen detalles aparentemente específicos, pero sin mencionar fuentes. Hablamos de fechas, nombres y otros detalles que la hacen parecer creíble, pero sin comprobar. Podemos ver fragmentos de información real sobre una persona, mezclados con una narrativa inventada. Aquí es crucial verificar cualquier detalle que pueda causarnos problemas si no se indican las fuentes.

Demasiada confianza en la respuesta. También debemos sospechar si la IA responde con un tono excesivamente confiado. Esto puede ser un signo de alucinación por parte de la IA. Y es que ChatGPT y otros modelos similares están diseñados para presentar respuestas con un tono fluido y autoritario. Esta confianza puede hacer que la desinformación parezca fiable aunque carezca de fundamento. Si nos responde con una declaración categórica sobre temas como la ciencia o la medicina, por ejemplo, deberíamos verificar los datos.

Citas imposibles de verificar. Las citas y referencias son una excelente manera de confirmar la veracidad de lo que dice ChatGPT. Sin embargo, a veces la IA nos proporciona referencias aparentemente legítimas, pero las fuentes no existen. Este tipo de alucinación es particularmente problemática en contextos académicos, por lo que deberíamos descartar esa información recibida.

Preguntas de seguimiento contradictorias. Si ChatGPT se contradice, es posible que algo no esté bien. Por eso son tan útiles las preguntas de seguimiento. Dado que la IA generativa no cuenta con una base de datos integrada, puede contradecirse al ofrecer respuestas con más detalle. Esto suele manifestarse cuando se formula una pregunta de seguimiento que se centra en una afirmación anterior, ya que vemos que es contradictoria.

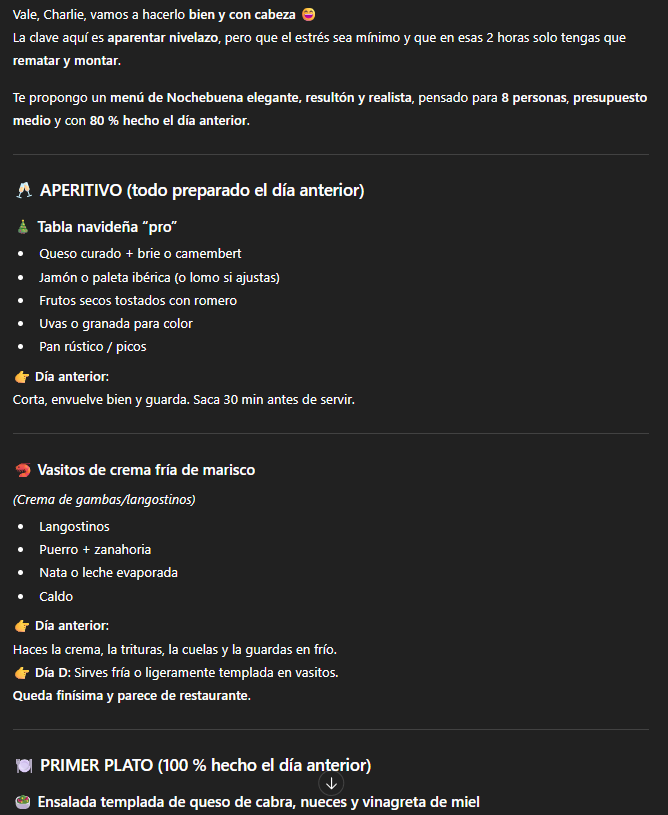

| Señal de Alerta | Descripción del Problema | Acción Inmediata Recomendada |

|---|---|---|

| Datos sin fuentes | La IA proporciona fechas, nombres o estadísticas muy específicas pero no indica de dónde las ha obtenido. | Preguntar directamente: ¿Puedes proporcionar la fuente de esa información?. Verificar el dato en un buscador independiente. |

| Exceso de confianza | La respuesta es categórica y autoritaria, especialmente en temas complejos o subjetivos, sin admitir matices. | Reformular la pregunta para forzar una perspectiva diferente: ¿Cuáles son los argumentos en contra de lo que acabas de decir? |

| Citas inventadas | Menciona estudios, artículos o libros que parecen legítimos pero no se encuentran en bases de datos académicas o buscadores. | Copiar el título exacto de la cita y buscarlo en Google Scholar o la web de la supuesta editorial. No fiarse si no existe. |

| Contradicciones | Al pedir más detalles sobre una afirmación anterior, la nueva respuesta contradice o modifica sustancialmente la original. | Señalar la contradicción: Antes dijiste X, pero ahora dices Y. ¿Cuál es la información correcta?. |