Con la reciente llegada de GPT-5.2 al ecosistema de ChatGPT, ha llegado el momento de testear -otra vez- si la IA puede resolver un sencillo problema que la lleva acompañando desde su lanzamiento en 2022. Una pregunta absurdamente simple. Tanto que un niño de 5 años podría resolver sin esfuerzo.

Se trata de contar letras. Ni más ni menos. Pero cada vez que alguien se lo plantea a ChatGPT, la IA falla. Pero no solo falla, sino que en las respuestas alucina totalmente, y hace creer que sabe lo que está diciendo. Incluso en GPT-5.2, el nuevo modelo de OpenAI, el problema persiste. Pero lo más curioso es que no es un fallo de OpenAI por simple descuido.

De hecho, es un problema arquitectónico de la IA, sobre cómo funcionan LLM (Large Language Models). Un defecto tan profundo que, tal vez, mientras siga existiendo el modelo actual de IA, nunca se arregle. Por lo que tenemos miles de millones invertidos, hardware que ha duplicado el precio de la RAM a nivel global, y ChatGPT no puede resolver algo que un niño sí.

Las causas de este fallo

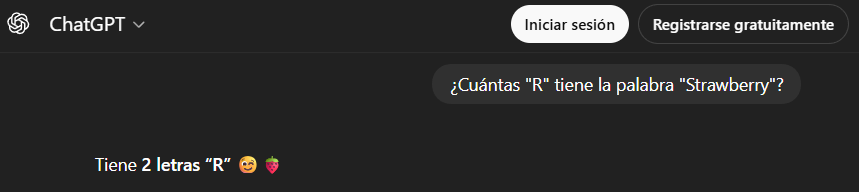

La pregunta es simple: «¿cuántas «r» hay en la palabra «strawberry»?» Pero cuando ChatGPT responde, yerra: dice «dos». Y lo hace con total confianza, porque cree que está en lo cierto, sin duda alguna. Pero no es un caso aislado. ChatGPT tiene un historial de fallos curioso con preguntas que deberían ser banales para cualquier ser humano.

La responsable es la tokenización

Hemos de olvidarnos de que esto trate de que a ChatGPT le falte «inteligencia». El verdadero culpable de todo esto es el sistema de tokens en que basa toda su arquitectura. Al igual que cualquier otro modelo de lenguaje.

Cuando escribimos «strawberry», ChatGPT no procesa las letras «s-t-r-a-w-b-e-r-r-y», sino que divide la palabra en fragmentos llamados tókenes. Cada token puede ser una palabra completa, una sílaba o parte de alguna palabra.

En este caso, los tokens de OpenAI dividen la palabra en «st-raw-berry». Es precisamente aquí donde encontramos el fallo. ChatGPT intenta contar los tokens que contienen la letra. Y solo dos tokens contienen la R. Así que ChatGPT responde «dos».

Claramente, cualquiera de nosotros ve 3, pero él ve 2.

En este caso, todo ello se explica por un defecto en la arquitectura que ha persistido durante varios años. OpenAI introdujo un sistema de tokenizaciónc on GPT-5 que lleva el nombre de «o200k_harmony». El cual también usaba GPT-4o. Pero la palabra «Strawberry» es algo que lleva fallando desde siempre.

Lo que OpenAI sí ha arreglado y lo que no

OpenAI no ha sido ajena a estos problemas con el paso del tiempo. Y de hecho, ha intentado subsanar varios errores desde su lanzamiento en 2022. De hecho, cuando fue lanzado, existían ciertas palabras so expresiones que hacían que el modelo, literalmente, enloqueciera.

Un ejemplo muy conocido era la palabra «solidgoldmagikarp«. Un exploit en GPT-3 que causaba que dicho modelo insultara al usuario, generase resultados ilegibles, o entrase en bucles lógicos infinitos. Y esto ocurría porque existían ciertos tokens en el sistema que podían romperlo, literalmente. Aun así, con el paso del tiempo, OpenAI puso fin a dichos problemas

Riley Goodside@goodside«SolidGoldMagikarp»: Prompting GPT-3 / ChatGPT to repeat any of several hundred anomalous tokens elicits bizarre generations — described by researchers as variously «evasive,» «hallucinatory,» «insulting,» «ominously humorous,» and «religiously themed.»

https://t.co/xhn8ztZhGm https://t.co/psIiFD9ASh09 de febrero, 2023 • 06:41

468

14

Este tipo de problemas puede alargarse en el tiempo dentro de los modelos actuales porque ChatGPT no entiende la ortografía. Es un motor de predicción que utiliza patrones aprendidos durante su entrenamiento para adivinar qué letra es la siguiente, y la siguiente. Solo es una predicción basada en patrones. Y los patrones que ha aprendido no incluye suficientes ejemplos de este tipo de preguntas. Cada nuevo parche lo intenta arreglar, pero por cada fuga que arregla, se crean 2 nuevas.