ChatGPT ha ganado popularidad no solo por ser una de las primeras grandes inteligencias artificiales accesibles al público general, sino porque, desde el principio, ha permitido utilizar sus modelos de lenguaje de forma gratuita. Cualquier usuario podía iniciar una conversación y obtener respuestas sin pasar por caja, aunque siempre con ciertas limitaciones.

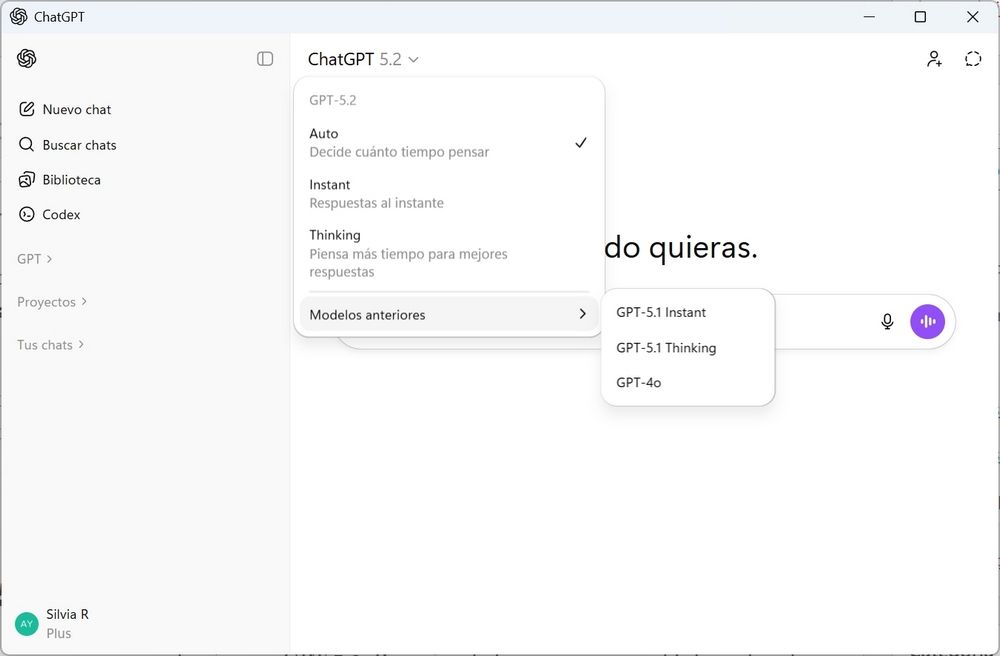

Cuando iniciamos una conversación en ChatGPT, la plataforma se encargaba de elegir automáticamente el modelo más adecuado en función de la complejidad de la pregunta o de la tarea que le pidiéramos. Los dos modelos que ofrece, principalmente, son los siguientes:

- Instant. Está diseñado para ofrecer respuestas prácticamente inmediatas, priorizando la velocidad y la eficiencia. Es el modelo que se emplea en consultas sencillas, tareas repetitivas o peticiones que no requieren un razonamiento complejo.

- Thinking. Por su parte, este activa un modo de razonamiento más profundo. Este modelo dedica más recursos al análisis del contexto y a la elaboración de la respuesta, lo que se traduce en resultados más precisos y elaborados cuando nos enfrentamos a preguntas técnicas, problemas complejos o tareas que exigen un mayor nivel de comprensión.

ChatGPT utiliza un modo automático que permite a la propia IA elegir cuál de los dos tipos del modelo de lenguaje quiere usar en función de la petición que se le haga. Sin embargo, esto le cuesta mucho dinero a OpenAI, ya que el modelo «Thinking» requiere mucha más capacidad de computación y es mucho más caro que el modelo «Instant». Y, por ello, ha tomado la decisión de capar esta posibilidad.

ChatGPT usará el modo «Instant» por defecto

GPT-5.2 Instant es la variante más económica y rápida de la familia de modelos GPT de OpenAI. No es tan preciso como el Thinking para tareas complejas, pero sí que es suficiente para casi el 90% de las preguntas que se hacen a la IA. Por ello, OpenAI ha decidido eliminar el enrutamiento del modo automático a los usuarios que utilicen la versión gratuita de la IA o paguen la suscripción de la versión Go, la más barata. De esta forma, a partir de ahora, los usuarios que quieran aprovecharse de las capacidades más avanzadas (por ejemplo, respuestas complejas o más detalladas), deberán seleccionar manualmente el modelo «Thinking» directamente desde el menú de herramientas.

Este cambio se debe, según muchas fuentes, a un esfuerzo por parte de OpenAI por reducir costes operativos significativos. El sistema de enrutamiento automático estaba llevando a los usuarios gratuitos (o del plan barato) al modelo más avanzado automáticamente, lo que ha aumentado mucho los costes de computación y, al mismo tiempo, no estaba generando ingresos directos proporcionales. Esto ha llevado a la empresa a enfrentarse a una importante presión financiera interna, lo que le ha obligado a cortar a la fuerza esta fuga de dinero.

Los usuarios de pago (dentro de los planes Plus y Pro) continuarán teniendo acceso a sistemas de enrutamiento automático, así como a los modelos más avanzados sin necesidad de tener que hacer el cambio manualmente.

Por ahora, OpenAI no va a eliminar el modelo «Thinking» a los usuarios del plan gratuito, pero sí que hará que sea más engorroso seleccionarlo. De esta forma, podrá ahorrarse algunos miles de millones de dólares para ver si consigue reducir la presión financiera, ya que, de no ser así, todos los usuarios de ChatGPT podrían ver limitadas aún más sus funciones, pudiendo afectar incluso a aquellos que pagan por las versiones más avanzadas.